Czym jest fine tuning modeli AI – to pytanie wraca dziś w niemal każdej firmie, która bawi się już ChatGPT-em, Claude’em czy Geminim i zaczyna marzyć o „własnym” chatbotcie. Na demo wszystko działa idealnie, ale gdy model dostaje pytania o konkretny regulamin, wewnętrzne procedury czy cennik – nagle zaczyna zgadywać albo odpowiadać półprawdami. Wtedy pada magiczne zdanie: „To może zróbmy fine tuning”.

Wyobraź sobie polską firmę usługową: setki stron procedur, tysiące maili z obsługi klienta, dziesiątki wariantów umów. Zespół IT dostaje zadanie: „Chcemy, żeby chatbot odpowiadał jak nasi najlepsi konsultanci, ale 24/7 i po polsku”. Kusząca obietnica brzmi: „dostroimy model na naszych danych i wszystko będzie śmigać”. W praktyce to już nie tylko zabawa promptami, ale projekt z budżetem, ryzykiem i bardzo konkretnymi konsekwencjami technicznymi.

W tym przewodniku spróbujemy spokojnie, krok po kroku odpowiedzieć na pytanie: czym jest fine tuning, kiedy naprawdę ma sens, kiedy lepiej postawić na sprytne promptowanie i RAG, a kiedy w ogóle odpuścić temat. Tekst jest dla osób technicznych, ale nie wymaga doktoratu z uczenia maszynowego – raczej trzeźwego myślenia o produkcie, danych i kosztach.

Po co firmom własny chatbot? Krótka scena z życia

Zanim przejdziemy do definicji, warto zrozumieć problem, który fine tuning ma rozwiązać.

Typowy scenariusz wygląda tak:

- Firma wdraża prostego chatbota opartego na modelu typu GPT-4o, Claude czy Gemini.

- Na początku używa tylko prompt engineeringu: „Zachowuj się jak polski doradca klienta, odpowiadaj konkretnie, odwołuj się do regulaminu X”.

- Po tygodniu okazuje się, że:

- chatbot myli stare i nowe warunki promocji,

- nie rozumie specyficznych skrótów używanych w branży,

- odpowiada dobrze po angielsku, ale gorzej po polsku,

- czasem jest zbyt „kreatywny” tam, gdzie trzeba sztywnych procedur.

Na tym etapie padają trzy propozycje:

- Lepszy prompt – dopisać więcej instrukcji, przykładów, ton wypowiedzi.

- RAG (Retrieval-Augmented Generation) – dodać bazę dokumentów, z których model będzie „ściągał” aktualne informacje.

- Fine tuning – dostroić model na przykładach rozmów i dokumentów firmowych, żeby „myślał” jak nasza organizacja.

Wybór między tymi trzema podejściami to w praktyce decyzja biznesowa, a nie tylko techniczna. Dlatego najpierw nazwijmy rzeczy po imieniu.

Czym jest fine tuning modeli AI? Definicja po ludzku

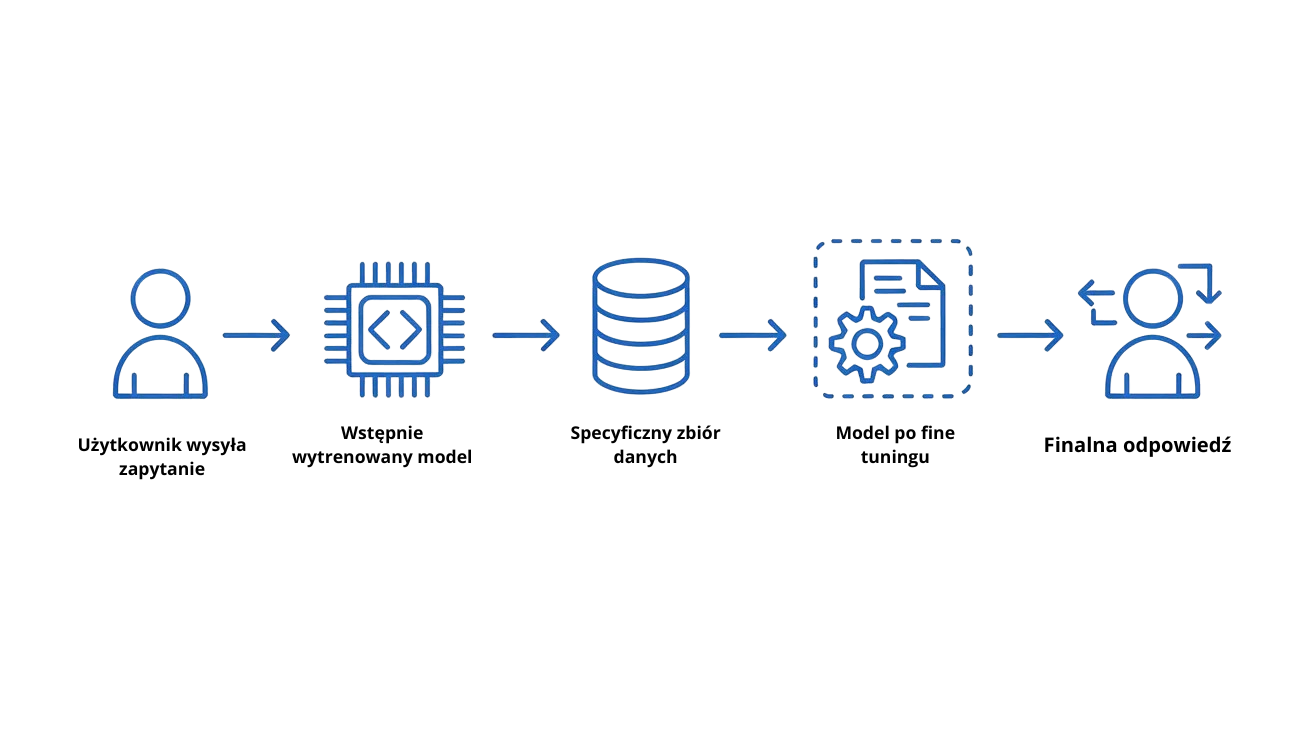

Fine tuning to proces dalszego trenowania już istniejącego, dużego modelu językowego (foundation modelu) na nowych, bardziej wyspecjalizowanych danych. Zamiast budować model od zera, bierzemy gotowy „mózg” i uczymy go nowych nawyków, stylu i wiedzy.

Dostawcy tacy jak OpenAI, Google, Meta czy Anthropic opisują fine tuning jako sposób dopasowania pretrenowanego modelu do konkretnego zadania, branży lub roli – na przykład obsługi klienta w banku, analizy dokumentów prawnych czy generowania kodu w określonym stylu.

Ważne elementy definicji:

- Startujemy z modelu bazowego (foundation model) – ogromny model, trenowany na miliardach słów z Internetu, książek, kodu itp.

- Dostrajanie polega na dalszym treningu – podajemy modelowi nowe przykłady wejść i oczekiwanych odpowiedzi (supervised fine-tuning) albo przykłady ocen preferowanych odpowiedzi (RLHF, DPO).

- Zmieniają się parametry modelu – informacje z naszych danych są „wypalane” w jego wagach, czyli stają się częścią pamięci długoterminowej modelu.

W efekcie dostrojony model:

- lepiej rozumie specyficzne słownictwo,

- częściej wybiera styl i ton pasujący do naszej marki,

- popełnia mniej błędów w typowych przypadkach z naszej domeny.

Ale cena za to jest konkretna: koszty obliczeniowe, ryzyko przeuczenia (overfittingu) oraz to, że model może stracić część ogólnych zdolności, jeśli fine tuning zostanie przeprowadzony nieumiejętnie.

Jak działa fine tuning modelu od kuchni (bez wzorów)

Nie będziemy wchodzić w równania, ale warto mieć w głowie ogólny schemat. Większość dostawców opisuje proces podobnie.

- Wybór modelu bazowego

Decydujesz, czy dostrajasz duży model ogólny (np. GPT-4o, Claude, Gemini, Llama 3) czy mniejszy, tańszy wariant specjalny. - Zdefiniowanie use case’u

Musisz jasno odpowiedzieć na pytanie: co dokładnie ma robić model?- Klasyfikować maile?

- Odpowiadać jak support?

- Pisać kod w określonym stylu?

- Przygotowanie danych treningowych

- Zbierasz przykłady realnych rozmów, dokumentów, zapytań.

- Anonimizujesz dane (usuwasz wrażliwe informacje).

- Normalizujesz format – np. JSONL z parą prompt–completion.

- Podział na zbiory: trening, walidacja, test

- Trening – większość danych, na których model się uczy.

- Walidacja – śledzenie, czy model nie zaczyna się przeuczać.

- Test – końcowe sprawdzenie, jak sobie radzi na nowych przykładach.

- Uruchomienie zadania fine tuningu

Robisz to przez panel, SDK albo API – np. w OpenAI, Azure OpenAI, Vertex AI, AWS Bedrock. Wybierasz m.in. liczbę epok, batch size, współczynnik uczenia. - Ewaluacja modelu

- Porównujesz wyniki z modelem bazowym.

- Sprawdzasz metryki (accuracy, F1, BLEU) oraz testy ręczne.

- Deployment i monitoring

- Tworzysz „customowy” endpoint (np. własny model-ID).

- Mierzysz jakość odpowiedzi, koszty, timeouty, zachowanie w edge case’ach.

Dla mniejszych organizacji często stosuje się lżejsze metody, tzw. PEFT (Parameter-Efficient Fine-Tuning), takie jak LoRA czy QLoRA, które dodają małe warstwy na wierzchu istniejącego modelu zamiast modyfikować wszystkie parametry. To drastycznie obniża koszty i wymagania sprzętowe.

Fine tuning vs prompt engineering – kiedy wystarczy dobry prompt

Częsty błąd: ktoś widzi niedoskonałe odpowiedzi i od razu chce „trenować model”. Tymczasem bardzo często wystarcza porządny prompt engineering.

Prompt engineering polega na takim formułowaniu zapytań i instrukcji, żeby model lepiej rozumiał, czego potrzebujemy – bez zmiany jego parametrów. Możemy:

- definiować rolę („Jesteś polskim doradcą podatkowym…”),

- podawać przykłady (few-shot learning),

- narzucać strukturę (sekcje odpowiedzi, format JSON),

- określać ton, długość, szczegółowość odpowiedzi.

Kiedy wystarczy prompt engineering?

- Gdy problem dotyczy głównie stylu (zbyt „luźny” albo zbyt sztywny język).

- Gdy chcesz narzucić format odpowiedzi (np. tabelka, JSON, bullet-pointy).

- Gdy model generalnie wie, o co chodzi, ale trzeba go „ułożyć” co do sposobu tłumaczenia czy pisania.

Kiedy sięgać po fine tuning zamiast tylko po prompt?

- Gdy model konsekwentnie myli pojęcia w konkretnej dziedzinie (np. nazwy własnych produktów).

- Gdy potrzebujesz wysokiej powtarzalności zachowania w konkretnym schemacie dialogu.

- Gdy chcesz ustandaryzować styl i decyzje w setkach tysięcy interakcji (np. rozpatrywanie reklamacji według wewnętrznych procedur).

Dobra praktyka z dokumentacji wielu dostawców jest prosta: najpierw maksymalnie wykorzystaj prompt engineering (i ewentualnie RAG), a dopiero potem myśl o fine tuningu.

Fine tuning vs RAG – kiedy lepiej dodać bazę wiedzy zamiast trenować model

Drugi wielki dylemat: fine tuning czy RAG (Retrieval-Augmented Generation)?

RAG polega na tym, że model przed wygenerowaniem odpowiedzi pobiera fragmenty zewnętrznych dokumentów (baza wiedzy, regulaminy, bazy danych) i wykorzystuje je jako dodatkowy kontekst. Model sam w sobie się nie zmienia, ale ma „doczepioną” pamięć zewnętrzną.

Kluczowa różnica:

- Fine tuning – „wypalasz” wiedzę w parametrach modelu.

- RAG – trzymasz wiedzę w zewnętrznej bazie i tylko ją podajesz modelowi w inputach.

Kiedy RAG wygrywa z fine tuningiem?

- Gdy treści często się zmieniają (cenniki, regulaminy, artykuły na blogu).

- Gdy dane są obszerne i bogate (cała dokumentacja techniczna, dziesiątki tysięcy stron).

- Gdy musisz śledzić aktualność informacji (np. prawo podatkowe, kursy walut).

- Gdy nie chcesz ryzykować, że model „poprzekręca” wiedzę – w RAG zawsze możesz pokazać źródło.

Kiedy fine tuning jest lepszy od samego RAG?

- Gdy zależy Ci na stylu, tonie i zachowaniu (np. „nasz chatbot ma mówić jak nasza marka”).

- Gdy zadanie jest wąskie i powtarzalne – np. klasyfikacja zgłoszeń, analiza sentymentu, routing.

- Gdy chcesz, by model intuicyjnie rozumiał skróty i slang używane w organizacji, zamiast czytać je za każdym razem z dokumentu.

W praktyce: w wielu projektach najlepszy efekt daje połączenie RAG + delikatny fine tuning na przykładach dialogów i instrukcji. Wtedy RAG dostarcza aktualnej wiedzy, a fine tuning dopasowuje zachowanie i interpretację.

Zastosowania fine tuningu w biznesie i edukacji

Dlaczego tyle firm inwestuje dziś czas i pieniądze w fine tuning? Przykładów jest sporo – od dokumentacji Google i OpenAI po case studies dużych integratorów AI.

Typowe zastosowania:

1. Chatboty do obsługi klienta

- Model uczony na historii rozmów z klientami, gotowych odpowiedziach, skryptach rozmów.

- Fine tuning uczy go, jakie rozwiązania są akceptowalne, a jakie należy eskalować do człowieka.

- Często łączony z RAG, żeby odpowiadał na podstawie aktualnych regulaminów.

2. Klasyfikacja i routing zgłoszeń

- Automatyczne przypisywanie ticketów do kategorii i zespołów.

- Fine tuning na zanonimizowanych danych z systemu ticketowego.

- Przy dużych wolumenach pozwala znacząco odciążyć pierwszy poziom supportu.

3. Analiza tekstu i dokumentów

- Analiza umów, opinii klientów, ankiet, transkrypcji rozmów call center.

- Model dostrojony do wyłapywania konkretnego typu ryzyka, emocji lub naruszeń procedur.

4. Generowanie kodu i asystenci programisty

- Fine tuning na wewnętrznych repozytoriach kodu, standardach review, stylu commitów.

- Asystent, który zna stack firmy i generator zadań DevOps może znacznie przyspieszyć pracę.

5. Edukacja i personalizacja treści

- Modele dostrojone do poziomu uczniów, programu nauczania i stylu szkoły/uczelni.

- Chatbot-tutor, który tłumaczy zagadnienia w określony sposób i używa autorskich materiałów.

W każdym z tych scenariuszy kluczem są dobre dane treningowe i jasno zdefiniowany cel – bez tego fine tuning często tylko zwiększa koszty bez realnej poprawy jakości.

Przykładowe use case’y krok po kroku

Przyjrzyjmy się trzem scenariuszom, w których fine tuning faktycznie ma sens.

Use case 1: Chatbot dla banku

Cel: chatbot odpowiadający na pytania o produkty bankowe, procedury i proste problemy klientów.

- Analiza potrzeb – bank decyduje, że chatbot ma obsługiwać przede wszystkim pytania o konta osobiste, kredyty gotówkowe i karty.

- Dane treningowe – zanonimizowane transkrypcje rozmów z call center, FAQ, skrypty rozmów, procedury.

- RAG + fine tuning – dokumenty produktowe idą do bazy RAG, natomiast przykłady rozmów i styl odpowiedzi – do fine tuningu.

- Ewaluacja – testy wewnętrzne, A/B test z częścią realnego ruchu.

- Bezpieczeństwo – precyzyjne filtry promptów, limity na podejmowanie decyzji finansowych, obowiązkowa eskalacja w wątpliwych przypadkach.

Use case 2: Support SaaS dla małej firmy technologicznej

Cel: automatyzacja pierwszej linii wsparcia technicznego.

- Start od RAG – dokumentacja produktu, changelogi, artykuły z help center lądują w bazie dokumentów.

- Zbieranie przykładów – realne zgłoszenia klientów + odpowiedzi supportu, posegregowane na kategorie.

- Fine tuning – model uczony na tym, jak odpowiada support, jak zadaje pytania doprecyzowujące i kiedy prosi o logi.

- Rezultat: model „czuje” produkt, zadaje podobne pytania jak człowiek z supportu, a RAG dostarcza najświeższe informacje o wersjach.

Use case 3: Asystent programisty w firmie

Cel: przyspieszenie pracy nad kodem w konkretnym stacku (np. Python + Django + React).

- Dane treningowe – fragmenty kodu z repozytoriów, PR-y, przykłady „dobrych rozwiązań”, dokumentacja wewnętrzna.

- Fine tuning – model uczy się preferowanego stylu pisania, architektury, konwencji nazw.

- RAG – dokumentacja projektów i wątki z systemu ticketowego dołączone jako kontekst.

- Efekt: model generuje kod w stylu firmy, proponuje rozwiązania zgodne z architekturą, a nie tylko „ogólnie poprawne”.

Fine tuning – plusy i minusy (w pigułce)

Zalety fine tuningu

| Zaleta | Co to daje w praktyce? |

|---|---|

| Wyższa jakość w konkretnej domenie | Lepsze odpowiedzi w wąskiej specjalizacji niż model ogólny. |

| Stabilny styl i zachowanie | Chatbot zachowuje się bardziej przewidywalnie, mniej „humorów” modelu. |

| Mniejsze koszty przy dużym wolumenie | Dostrojony mniejszy model może zastąpić duży model ogólny w masowych zastosowaniach. |

| Lepsza praca z edge case’ami | Model uczy się rzadkich, ale krytycznych sytuacji z Twoich danych. |

| Możliwość offline / on-premises | W przypadku otwartych modeli (Llama, Gemma) – pełna kontrola nad wdrożeniem. |

Wady i ryzyka fine tuningu

| Ryzyko / wada | Dlaczego to problem? |

|---|---|

| Wysokie koszty obliczeniowe | Trening wymaga mocnych GPU/TPU lub płatnej infrastruktury chmurowej. |

| Ryzyko przeuczenia (overfitting) | Model świetny na Twoich danych, ale gubi ogólną wiedzę i gorzej radzi sobie poza nimi. |

| Zanieczyszczone dane | Błędy, uprzedzenia, nieaktualne informacje zostaną „utrwalone” w modelu. |

| Trudniejsze aktualizacje | Zmiana regulaminu wymaga ponownego fine tuningu, a nie tylko podmiany dokumentu w RAG. |

| Bezpieczeństwo i prywatność danych | Dane treningowe mogą zawierać informacje wrażliwe – wymagają anonimizacji i zgodności z RODO. |

| Uzależnienie od dostawcy | Czasem dostrojony model działa tylko w jednej chmurze / ekosystemie. |

Jak przeprowadzić projekt fine tuningu w małej lub średniej firmie

Dla MŚP fine tuning nie musi oznaczać wielomilionowego projektu. Ale kilka kroków jest absolutnie kluczowych.

1. Najpierw prosty POC na modelu bazowym

- Testujesz use case na gotowym modelu z dobrym prompt engineeringiem + ewentualnym RAG.

- Mierzysz jakość odpowiedzi, czas reakcji, koszty per 1000 zapytań.

Jeśli już tu jest bardzo dobrze – fine tuning może nie być potrzebny.

2. Precyzyjne zdefiniowanie KPI

- Jak zmierzysz, że fine tuning się opłacił?

- mniej błędnych odpowiedzi,

- krótszy czas obsługi,

- mniejszy wolumen zgłoszeń do człowieka,

- niższy koszt per zapytanie dzięki mniejszemu modelowi.

3. Kuracja danych

- Zbierasz przykłady dobrych i złych odpowiedzi, które chcesz poprawić.

- Czyścisz dane z nazwisk, PESEL-i, numerów kart, numerów umów – anonimowość to konieczność.

4. Wybór podejścia technicznego

- Dostrajanie modelu zamkniętego (OpenAI, Azure, AWS, Google) – łatwiejsza ścieżka, ale mniej kontroli.

- Dostrajanie modelu otwartego (Llama 3, Gemma) – więcej pracy, ale możesz działać lokalnie lub on-premises.

5. Iteracyjny fine tuning + ewaluacja

- Zaczynasz od małego eksperymentu na części danych.

- Porównujesz wyniki z modelem bazowym i konfiguracją RAG-only.

- Dopiero gdy widzisz istotną poprawę, rozszerzasz projekt.

Warto pamiętać, że przy każdym takim projekcie budujesz też kompetencje wewnętrzne. Dobre artykuły o AI i ekonomii, które tłumaczą takie decyzje biznesowe, znajdziesz na <a href=”https://decodethefuture.org/”>DecodeTheFuture.org</a> – tam właśnie można spiąć teorię z praktyką.

Najczęstsze błędy i mity wokół fine tuningu

Na koniec kilka mitów, które często przewijają się w rozmowach o fine tuningu modeli językowych.

„Fine tuning rozwiąże każdy problem z AI”

Nie, nie rozwiąże. Jeśli Twój model ma kiepskie dane wejściowe, źle ustawiony prompt, brak RAG i niejasny use case – dostrajanie tylko utrwali chaos w parametrach modelu.

„Bez fine tuningu nie da się zrobić profesjonalnego chatbota”

Wiele firm wdraża skuteczne chatboty wyłącznie na RAG + dobrym prompt engineeringu, bez żadnego fine tuningu. Dla wielu zastosowań to jest „domyślna” droga, a fine tuning to dopiero kolejny krok.

„Fine tuning to tylko trochę droższy prompt”

Fine tuning to normalny projekt ML: zbieranie danych, ich czyszczenie, konfiguracja treningu, testy, monitoring. W wielu przypadkach to bardziej inwestycja strategiczna niż szybki trik optymalizacyjny.

„Jak dostroimy model, to zawsze będzie aktualny”

Nie. Fine tuning „pieczętuje” wiedzę z chwili treningu. Gdy zmieni się prawo, oferta, kursy walut – model nadal będzie pamiętał starą wersję, dopóki nie przeprowadzisz aktualizacji (kolejny fine tuning) lub nie połączysz go z RAG-iem.

„Fine tuning jest niebezpieczny dla danych”

Może być – jeśli zrobisz go bez świadomości kwestii prywatności i zgodności z regulacjami. W praktyce dostawcy oferują tryby, w których Twoje dane nie są używane do trenowania modeli ogólnych, ale to wymaga świadomej konfiguracji i zrozumienia polityk danego usługodawcy.

FAQ: najczęstsze pytania o fine tuning modeli AI

1. Czym jest fine tuning modelu AI w prostych słowach?

Fine tuning to ponowne trenowanie gotowego modelu na Twoich danych, żeby lepiej rozumiał specyficzny język, zadania i styl komunikacji Twojej firmy. Zamiast budować model od zera, „dostrojasz” istniejący model, tak jak dostraja się radio do konkretnej stacji.

2. Czy naprawdę potrzebuję fine tuningu dla mojego chatbota?

Nie zawsze. Jeśli chatbot ma głównie odpowiadać na pytania na podstawie dokumentów (regulaminy, FAQ, artykuły), często wystarczy RAG i dobry prompt. Fine tuning ma sens, gdy chcesz, by chatbot zachowywał się jak konkretny typ pracownika (np. konsultant bankowy) i konsekwentnie stosował specyficzne procedury.

3. Czym różni się fine tuning od RAG?

Czym jest fine tuning w porównaniu z RAG? Fine tuning zapisuje wiedzę w parametrach modelu, natomiast RAG podaje modelowi fragmenty dokumentów jako dodatkowy kontekst w czasie odpowiedzi. RAG łatwiej aktualizować (wystarczy podmienić dokumenty), fine tuning lepiej nadaje się do uczenia stylu i nawyków modelu.

4. Czy fine tuning modeli językowych jest drogi?

Fine tuning dużych modeli może być kosztowny – wymaga mocy obliczeniowej i dobrze przygotowanych danych. Dostawcy chmury oferują jednak także tańsze warianty oraz techniki takie jak PEFT (LoRA, QLoRA), dzięki którym mniejsze firmy mogą sobie pozwolić na dostrajanie bez ogromnych budżetów.

5. Czy fine tuning zastępuje prompt engineering?

Nie. Nawet po udanym fine tuningu nadal potrzebujesz przemyślanego prompt engineeringu – jasnych instrukcji, formatu odpowiedzi, przykładów. Fine tuning i prompt engineering uzupełniają się: jeden zmienia zachowanie modelu „od środka”, drugi mówi mu, jak ma odpowiadać „od zewnątrz”.

6. Czy fine tuning jest bezpieczny dla danych firmowych?

Może być bezpieczny, jeśli zadbasz o anonimizację danych, właściwe umowy z dostawcą i konfigurację polityk prywatności. Warto sprawdzić, czy dane z fine tuningu są używane tylko do Twojego modelu, czy również do trenowania modeli ogólnych, oraz jakie są procedury ich przechowywania.

7. Jak sprawdzić, czy projekt naprawdę potrzebuje fine tuningu?

Zanim zapytasz „Czym jest fine tuning i jak go wdrożyć?”, zapytaj:

- Czy wykorzystałem już dobrze prompt engineering i RAG?

- Czy problem dotyczy wiedzy, stylu, czy powtarzalności zachowań?

- Czy mam wystarczająco dużo dobrych, zanonimizowanych danych?

Jeśli odpowiedzi są twierdzące, a model bazowy nadal nie spełnia oczekiwań, wtedy fine tuning staje się sensowną opcją.

Bibliografia

- OpenAI. (2024). Fine-tuning models (OpenAI Platform Docs). Dostęp: https://platform.openai.com/docs/guides/fine-tuning OpenAI

- OpenAI. (2024). Model optimization – supervised fine-tuning, DPO and RL (OpenAI Platform Docs). Dostęp: https://platform.openai.com/docs/guides/model-optimization OpenAI

- OpenAI. (2024). Fine-tuning now available for GPT-4o. Dostęp: https://openai.com/index/gpt-4o-fine-tuning/ OpenAI

- Google Cloud. (2024). Fine-tuning LLMs: overview and guide. Dostęp: https://cloud.google.com/use-cases/fine-tuning-ai-models Google Cloud

- Google Cloud. (2024). Introduction to tuning – Vertex AI Generative AI. Dostęp: https://docs.cloud.google.com/vertex-ai/generative-ai/docs/models/tune-models Google Cloud Documentation

- Google Cloud. (2025). Tune Gemini models by using supervised fine-tuning. Dostęp: https://docs.cloud.google.com/vertex-ai/generative-ai/docs/models/gemini-use-supervised-tuning Google Cloud Documentation

- Google. (2024). Gemma model fine-tuning – Google AI for Developers. Dostęp: https://ai.google.dev/gemma/docs/tune Google AI for Developers

- Meta AI. (2024). Introducing Meta Llama 3. Dostęp: https://ai.meta.com/blog/meta-llama-3/ ai.meta.com

- Meta AI / Hugging Face. (2024). Meta-Llama-3-8B-Instruct – Model card. Dostęp: https://huggingface.co/meta-llama/Meta-Llama-3-8B-Instruct Hugging Face

- Meta. (2024). Fine-tuning Llama models – Llama Docs. Dostęp: https://www.llama.com/docs/how-to-guides/fine-tuning/ llama.com

- AWS. (2024). Fine-tune Anthropic’s Claude 3 Haiku in Amazon Bedrock. Dostęp: https://aws.amazon.com/blogs/machine-learning/fine-tune-anthropics-claude-3-haiku-in-amazon-bedrock-to-boost-model-accuracy-and-quality/ Amazon Web Services, Inc.

- AWS. (2024). Best practices and lessons for fine-tuning Anthropic’s Claude 3 Haiku on Amazon Bedrock. Dostęp: https://aws.amazon.com/blogs/machine-learning/best-practices-and-lessons-for-fine-tuning-anthropics-claude-3-haiku-on-amazon-bedrock/ Amazon Web Services, Inc.

- AWS. (2024). What is Retrieval-Augmented Generation (RAG)? Dostęp: https://aws.amazon.com/what-is/retrieval-augmented-generation/ Amazon Web Services, Inc.

- IBM. (2024). RAG vs. Fine-tuning – What’s the difference? Dostęp: https://www.ibm.com/think/topics/rag-vs-fine-tuning IBM

- IBM. (2024). What is retrieval augmented generation (RAG)? Dostęp: https://www.ibm.com/think/topics/retrieval-augmented-generation IBM

- Oracle. (2024). RAG vs. Fine-Tuning: How to Choose. Dostęp: https://www.oracle.com/artificial-intelligence/generative-ai/retrieval-augmented-generation-rag/rag-fine-tuning/ Oracle

- Red Hat. (2024). RAG vs. fine-tuning. Dostęp: https://www.redhat.com/en/topics/ai/rag-vs-fine-tuning redhat.com

- AWS Prescriptive Guidance. (2024). Comparing Retrieval Augmented Generation and fine-tuning. Dostęp: https://docs.aws.amazon.com/prescriptive-guidance/latest/retrieval-augmented-generation-options/rag-vs-fine-tuning.html Dokumentacja AWS

- NVIDIA. (2025). What Is Retrieval-Augmented Generation aka RAG. Dostęp: https://blogs.nvidia.com/blog/what-is-retrieval-augmented-generation/ NVIDIA Blog

- Datacamp. (2024). Fine-Tuning Llama 3 and Using It Locally: A Step-by-Step Guide. Dostęp: https://www.datacamp.com/tutorial/llama3-fine-tuning-locally DataCamp

- Datacamp. (2024). GPT-4o Vision Fine-Tuning: A Guide With Examples. Dostęp: https://www.datacamp.com/tutorial/gpt-4o-vision-fine-tuning DataCamp

- Mohanty, D. (2024). Fine-Tuning GPT-4 Models with OpenAI API: A Step-by-Step Guide. Medium. Medium

- Neptune.ai. (2024). Fine-Tuning Llama 3 with LoRA: Step-by-Step Guide. Dostęp: https://neptune.ai/blog/fine-tuning-llama-3-with-lora neptune.ai

- Google Cloud. (2025). Hundreds of organizations are fine-tuning Gemini models. Dostęp: https://cloud.google.com/transform/top-five-gen-ai-tuning-use-cases-gemini-hundreds-of-orgs Google Cloud

- Wikipedia. (2025). Retrieval-augmented generation. Dostęp: https://en.wikipedia.org/wiki/Retrieval-augmented_generation Wikipedia

2 komentarze do “Czym jest fine tuning modeli AI i kiedy warto go używać?”